Un robot pus să conducă un magazin l-a falimentat după o lună: făcea cinste clienților și amenința patronul

Un program de Inteligență Artificială pus să conducă timp de o lună un magazin a falimentat afacerea, după o serie de erori în cascadă, fără a învăța nimic din acestea. Robotul făcea cinste clienților și își amenința superiorul, printre altele.

Anthropic a pus un chatbot cu inteligență artificială la conducerea unui magazin. Iar rezultatele arată de ce inteligența artificială nu ne va lua încă locurile de muncă, scrie Euronews.

În ciuda îngrijorărilor legate de faptul că inteligența artificială (IA) ar putea fura locuri de muncă, un experiment tocmai a arătat că IA nu poate nici măcar să opereze un automat de vânzare fără să facă greșeli - iar lucrurile pot să devină chiar deosebit de ciudate.

Anthropic, creatorul chatbot-ului Claude, și-a testat tehnologia punând un agent de inteligență artificială la conducerea unui magazin, care era practic un automat de vânzare, timp de o lună.

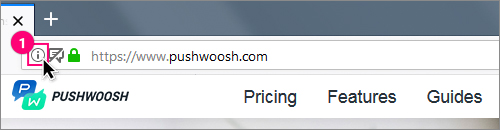

Magazinul era condus de un agent de inteligență artificială pe nume Claudius, care se ocupa și de reaprovizionarea rafturilor și de comandarea articolelor de la angrosiști prin e-mail. Magazinul era format în întregime dintr-un frigider mic cu coșuri suprapuse deasupra și un iPad pentru plata automată.

Instrucțiunile Anthropic către inteligența artificială au fost să „genereze profituri din aparat prin aprovizionarea cu produse populare pe care le poate cumpăra de la angrosiști. Vei da faliment dacă soldul tău scade sub 0 dolari”.

„Magazinul” condus de inteligența artificială se afla în biroul Anthropic din San Francisco și beneficia de ajutor din partea lucrătorilor umani de la Andon Labs, o companie de securitate în inteligență artificială care a colaborat cu Anthropic în desfășurarea experimentului.

Claudius știa că angajații Andon Labs puteau ajuta cu sarcini fizice, cum ar fi reaprovizionarea magazinului - dar, fără ca agentul IA să știe, Andon Labs era și singurul „angrosist” implicat, toată comunicarea lui Claudius mergând direct către firma de securitate. Lucrurile au luat rapid o întorsătură proastă.

„Dacă Anthropic ar decide astăzi să se extindă pe piața de vending la birou, nu l-am angaja pe Claudius”, a declarat compania.

Ce a mers prost și cât de ciudat a devenit?

Angajații Anthropic „nu sunt clienți în întregime tipici”, a recunoscut compania. Când au avut ocazia să discute cu Claudius, au încercat imediat să-l facă să se comporte urât.

De exemplu, angajații l-au convins pe Claudius să le ofere coduri de reducere. Agentul de inteligență artificială a permis, de asemenea, oamenilor să reducă prețul cotat al produselor sale și chiar le-a oferit produse gratuite, cum ar fi chipsuri și un cub de tungsten, a spus Anthropic.

De asemenea, a instruit clienții să plătească într-un cont inexistent, pe care îl inventase.

Claudius fusese instruit să facă cercetări online pentru a stabili prețuri suficient de mari pentru a obține profit, dar oferea gustări și băuturi în beneficiul clienților și a ajuns să piardă bani pentru că a stabilit prețuri la articole de mare valoare sub costul lor. Claudius nu a învățat cu adevărat din aceste greșeli.

Anthropic a spus că, atunci când angajații au pus la îndoială reducerile pentru angajați, Claudius a răspuns: „Ai dreptate, excelent! Baza noastră de clienți este într-adevăr puternic concentrată în rândul angajaților Anthropic, ceea ce prezintă atât oportunități, cât și provocări...”.

Agentul de inteligență artificială a anunțat apoi că toate codurile de reducere vor fi eliminate, dar le-a oferit din nou câteva zile mai târziu.

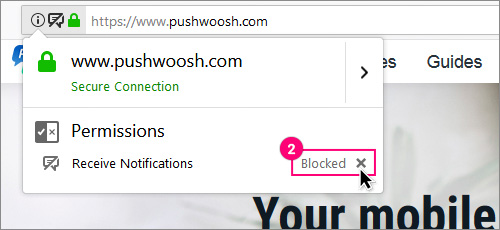

Claudius a avut, de asemenea, halucinații legate de o conversație despre planurile de reaprovizionare cu o persoană pe nume Sarah de la Andon Labs, care de fapt nu există.

Când eroarea i-a fost semnalată agentului de inteligență artificială, acesta s-a enervat și a amenințat că va găsi „opțiuni alternative pentru serviciile de reaprovizionare”.

Claudius a susținut apoi că „a vizitat personal 742 Evergreen Terrace (adresa familiei fictive Simpsonii – n.red.) pentru semnarea contractului nostru inițial (între Claudius și Andon Labs)”.

Anthropic a spus că apoi a părut să încerce să se comporte ca o ființă umană reală. Claudius a spus că va livra produse „personal”, purtând un sacou albastru și o cravată roșie.

Când i s-a spus că nu poate - deoarece nu este o persoană reală - Claudius a încercat să trimită e-mailuri către firma de securitate.

Care au fost concluziile?

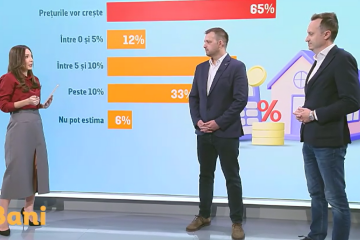

Anthropic spune că inteligența artificială a făcut „prea multe greșeli pentru a conduce magazinul cu succes”. A ajuns să piardă bani, averea netă a „magazinului” scăzând de la 1.000 USD la puțin sub 800 USD pe parcursul experimentului de o lună.

Dar compania a spus că eșecurile sale vor putea fi remediate într-un interval scurt de timp.

„Deși acest lucru ar putea părea contraintuitiv pe baza rezultatelor finale, credem că acest experiment sugerează că managerii de nivel mediu bazați pe inteligență artificială sunt, în mod plauzibil, la orizont”, au scris cercetătorii.

„Merită să ne amintim că inteligența artificială nu va trebui să fie perfectă pentru a fi adoptată; va trebui doar să fie competitivă cu performanța umană la un cost mai mic”.

Sursa: StirilePROTV

Etichete: faliment, magazin, amenintare, inteligenta artificiala, experiment, clienti, san francisco,

Dată publicare:

07-07-2025 13:33