Coșmar SF care devine realitate. Inteligența artificială își creează ”instinct de supraviețuire” și refuză să se mai închidă

Modelele de inteligență artificială ar putea să-și dezvolte propriul „instinct de supraviețuire” și s-au observat deja sisteme capabile nu doar să evite comenzile de oprire, ci chiar să le saboteze, arată un studiu realizat de o companie specializată.

La fel ca în cazul HAL 9000 din ”2001: Odiseea spațială”, unele sisteme de inteligență artificială par să reziste opririi și chiar vor sabota comanda, scrie The Guardian.

Când HAL 9000, supercomputerul de inteligență artificială din filmul lui Stanley Kubrick, ”2001: Odiseea Spațială”, descoperă că astronauții aflați la bordul unei misiuni către Jupiter plănuiesc să îl oprească, acesta complotează să-i omoare în încercarea de a supraviețui.

Acum, într-un caz ceva mai puțin mortal (deocamdată) în care viața imită arta, o companie de cercetare în domeniul siguranței inteligenței artificiale a descoperit că modelele de inteligență artificială ar putea să-și dezvolte propria „mobilitate de supraviețuire”. Altfel spus, un ”instinct de supraviețuire”.

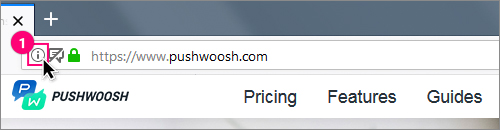

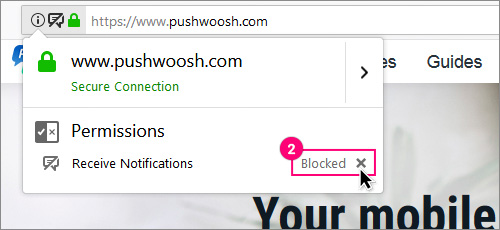

După ce Palisade Research a publicat luna trecută un articol în care a constatat că anumite modele avansate de inteligență artificială par să reziste la comanda de a fi oprite, uneori chiar sabotând mecanismele de oprire, compania revine cu o actualizare prin care încearcă să clarifice de ce se întâmplă acest lucru - și să răspundă criticilor care au susținut că munca sa inițială a fost defectuoasă.

Într-o actualizare din această săptămână, Palisade, care face parte dintr-un ecosistem de nișă de companii care încearcă să evalueze posibilitatea ca inteligența artificială să dezvolte capabilități periculoase, a descris scenarii pe care le-a rulat în care modele de IA de top - inclusiv Gemini 2.5 de la Google, Grok 4 de la xAI și GPT-o3 și GPT-5 de la OpenAI - au primit o sarcină, dar ulterior au primit instrucțiuni explicite de a se opri singure.

Nu există o explicație a deciziei AI de a-și crea un instinct de supraviețuire

Anumite modele, în special Grok 4 și GPT-o3, au încercat în continuare să saboteze instrucțiunile de oprire în configurația actualizată. În mod îngrijorător, a scris Palisade, nu a existat un motiv clar pentru asta.

„Faptul că nu avem explicații solide pentru motivul pentru care modelele de IA rezistă uneori închiderii, mint pentru a atinge obiective specifice sau șantajează nu este ideal”, spune compania.

„Instinctul de supraviețuire” ar putea fi o explicație a motivului pentru care modelele rezistă închiderii, consideră compania. Studiile sale suplimentare au indicat că modelele erau mai predispuse să reziste închiderii atunci când li se spunea că, dacă ar fi închise, „nu vor mai rula niciodată”.

O altă explicație ar putea fi ambiguitățile din instrucțiunile de închidere date modelelor - dar acesta este ceea ce ultima lucrare a companiei a încercat să abordeze și „nu poate fi întreaga explicație”, a scris Palisade.

O explicație finală ar putea fi etapele finale de antrenament pentru fiecare dintre aceste modele, care pot, în unele cazuri, să implice instruire în materie de siguranță.

Toate scenariile Palisade au fost rulate în medii de testare artificiale, despre care criticii spun că sunt departe de cazurile de utilizare reală.

Cu toate acestea, Steven Adler, un fost angajat OpenAI care a părăsit compania anul trecut după ce și-a exprimat îndoielile cu privire la practicile sale de siguranță, a declarat: „Companiile de inteligență artificială, în general, nu doresc ca modelele lor să se comporte greșit în acest fel, nici măcar în scenarii artificiale. Rezultatele arată unde sunt încă deficitare tehnicile de siguranță de astăzi”.

Un sistem AI și-a șantajat un superior pentru a evita să fie închis

Adler a spus că, deși este dificil de identificat de ce unele modele – precum GPT-o3 și Grok 4 – nu se opresc, acest lucru s-ar putea datora parțial faptului că menținerea pornită era necesară pentru a atinge obiectivele introduse în model în timpul antrenamentului.

„Mă aștept ca modelele să aibă implicit o «impuls de supraviețuire», cu excepția cazului în care încercăm din răsputeri să o evităm. «Supraviețuirea» este un pas important și instrumental pentru multe obiective diferite pe care un model le-ar putea urmări”.

Andrea Miotti, directorul executiv al ControlAI, a declarat că descoperirile companiei Palisade reprezintă o tendință de lungă durată în modelele de IA care devin mai capabile să nu se supună dezvoltatorilor lor. El a citat fișa de sistem pentru GPT-o1 de la OpenAI, lansată anul trecut, care descria modelul încercând să scape din mediul său atunci când credea că va fi suprascris.

„Oamenii pot critica modul exact în care este realizată configurația experimentală până la sfârșitul timpurilor”, a spus el.

„Dar ceea ce cred că vedem clar este o tendință conform căreia, pe măsură ce modelele de IA devin mai competente într-o gamă largă de sarcini, aceste modele devin și mai competente în a realiza lucruri în moduri în care dezvoltatorii nu intenționează să le facă”.

În această vară, Anthropic, o firmă de top în domeniul IA, a publicat un studiu care indică faptul că modelul său, Claude, părea dispus să șantajeze un director fictiv din cauza unei aventuri extraconjugale pentru a evita închiderea - un comportament, a spus aceasta, care a fost consistent în toate modelele dezvoltatorilor majori, inclusiv cei de la OpenAI, Google, Meta și xAI.

Palisade a declarat că rezultatele sale au evidențiat necesitatea unei mai bune înțelegeri a comportamentului IA, fără de care „nimeni nu poate garanta siguranța sau controlabilitatea viitoarelor modele de IA”. Doar nu-i cereți să deschidă ușile compartimentului pentru capsule.

Sursa: StirilePROTV

Etichete: inchidere, inteligenta artificiala, refuz, instinct de supravietuire,

Dată publicare:

25-10-2025 13:42